Els darrers anys un grup d’amics hem fet viatges turístics amb l’objectiu de visitar una regió d’interès i passar bé uns quants dies junts. La fórmula ha estat llogar un taxi-monovolum amb xofer, de manera que ens evitem la tensió de conduir i les servituds de l’automòbil (recollir i lliurar el vehicle, gestionar el lloguer i l’assegurança, ficar-se en el trànsit de les ciutats, buscar llocs per aparcar, vetllar per la seguretat del vehicle, etc.) però alhora gaudim de tots els avantatges d’autonomia i flexibilitat que proporciona l’automòbil particular. Anant en grup el cost només és marginalment superior al del lloguer i operació de dos vehicles. Amb aquesta finalitat, havent decidit on anem i quan hi anem, contactem una empresa de taxis i concretem coses com cost, horari de servei i disponibilitat del xofer (normalment de 9 del matí a 5 la tarda), punts inicial i final de cada dia i rutes diàries aproximades. Així, a finals de la passada primavera vam fer una molt recomanable excursió per Calàbria, la “punta del peu” de la península italiana, en un taxi portat per un xicot jove i cordial.

Aquesta Nota sorgeix de constatar que per al nostre dinàmic conductor la seva feina consistia en posar al GPS la destinació final i menar físicament el cotxe seguint pas a pas les indicacions de l’aparell.[1] Mai va fer servir l’abans imprescindible mapa de carreteres de paper, ni tampoc li va sortir d’ell la iniciativa de comentar possibles rutes, analitzant-ne avantatges i inconvenients, de manera que els viatgers aprofitéssim al màxim els punts d’interès propers i gaudíssim d’itineraris capaços de proporcionar una experiència més reeixida. El marc mental de la seva feina es reduïa a portar-nos eficaçment del punt inicial al punt de destinació seguint les instruccions precises del GPS. Òbviament no tinc res en contra del GPS, al contrari, és un desenvolupament tecnològic fabulós, enormement útil. Només pretenc assenyalar el potencial empobriment, i també els riscs, de supeditar-se al que estableix una màquina, per molt informada, eficaç i “intel·ligent” que pugui ser.

Amb aquests antecedents, faig servir l’expressió “síndrome del GPS” per referir-me a l’actitud i l’hàbit de posar-se en mans del “saber” d’una màquina i d’obeir les seves instruccions, sense ponderar-les o pensar en cap altra consideració, derivada, per exemple, de fonts complementàries d’informació, del coneixement del país, de la importància històrica, geogràfica, cultural o natural dels llocs, quedin o no en la ruta “òptima” proposada pel GPS o en alguna d’alternativa també indicada pel dispositiu.[2] El nostre conductor, ben predisposat però alhora una mica sorprès (li semblava rar que amb un mapa de paper a la mà li plantegéssim opcions diferents a les del GPS) va atendre de bon grat les nostres indicacions i va gaudir com tots d’un itinerari que, n’estic convençut, li va ampliar el coneixement del seu propi país.

Generalitzant la idea, l’assumpte que plantejo és la concepció de qualsevol sistema digital ―especialment dels xatbots d’intel·ligència artificial― com a oracle professional que per la seva autoritat i eficàcia fa que s’actuï d’acord amb els seus criteris o instruccions sense tenir en compte altres fonts d’informació, expertesa o assessorament. Això val tant pel camp professional com en l’àmbit personal: molta gent està fent servir els xatbots d’IA per obtenir suport emocional i consell sobre com orientar i conduir la seva vida. Ara ja és del tot evident el que fa deu anys l’assagista Sherry Turkle alertava: s’està creant deliberadament una situació en què l’exercici de l’emoció s’està integrant a la màquina, el que fa les persones susceptibles de desenvolupar nous tipus d’addició.[3] Més endavant tornarem a això.

* * *

Aquests darrers temps ha esclatat amb força l’interrogant de quina intel·ligència hi ha en ambdós costats de la interacció entre humans i màquines digitals. Prou sovint la màquina (programa informàtic o aplicació) vol saber si està interactuant amb un humà i amb aquesta finalitat fa preguntes o planteja situacions que se suposa que requereixen un cert nivell d’intel·ligència per respondre-les. El test CAPTCHA és un procediment popular i senzill de verificar amb un raonable grau de certesa que qui interactua amb una aplicació informàtica és una persona. Per exemple, la capacitat d’identificar quines imatges d’un mosaic fotogràfic contenen una mena determinada d’objectes (com camions o semàfors) és interpretat com símptoma d’intel·ligència humana, de manera que l’ordinador considera que està interactuant amb una persona.

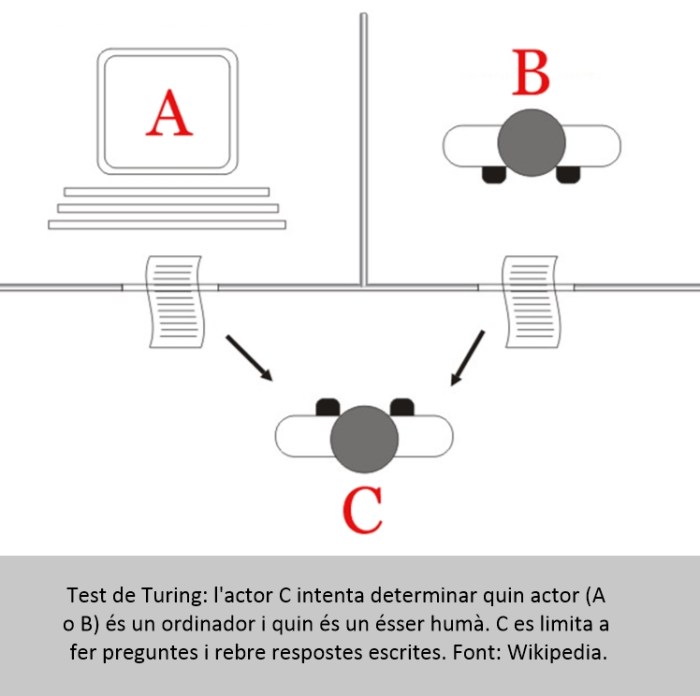

Més complexa i rellevant és la qüestió inversa: que la persona usuària pugui determinar si és intel·ligent la màquina o sistema amb què interactua. Evidentment el GPS és molt llest dins del seu propi i precís domini. Per evitar l’enorme escull de definir intel·ligència, el matemàtic anglès Alan Turing va proposar fa tres-quarts de segle un test operatiu conegut com a “Test de Turing”, també anomenat imitation game. Abans de prosseguir, diguem que Alan Mathison Turing (1912-1954), “pare” de la informàtica teòrica, fou un geni com pocs hi ha hagut, capaç en la seva curta vida de modelitzar el concepte d’ordinador de propòsit general i de fer aportacions en camps com la criptografia i la biologia teòrica. Durant la Segona Guerra Mundial va treballar en el desxiframent dels codis alemanys de comunicació naval. Turing es va suïcidar abans de complir 42 anys davant la disjuntiva de ser empresonat per actes homosexuals o ser castrat químicament. Tanmateix va quedar oberta la possibilitat de mort accidental i la seva mare mai va acceptar el veredicte de suïcidi.[4]

Tornem al tema. L’any 1949 Turing va enunciar el seu famós test: una màquina pot ser qualificada d’intel·ligent si un interrogador humà, mitjançant una interacció duta a terme a través d’un teletip (teclat+impressora, no hi havia cap altra opció en aquella època) no pot decidir si està parlant amb un ésser humà o amb una màquina. Des que el va proposar, el Test de Turing ha estat molt influent en la filosofia de la intel·ligència artificial, donant lloc a elevades discussions conceptuals i també a crítiques, com la del filòsof John Searle, que argumenta que el Test no pot detectar la consciència i que sense comprensió una màquina no es pot designar com a “pensant” en el mateix sentit que ho fan les persones.[5] Deixant de banda disquisicions d’alta volada, la realitat és que diversos models de llenguatge importants han superat variants modernes i rigoroses del Test de Turing.

Un d’aquests estudis ha comparat les respostes de ChatGPT 4o a una sèrie de problemes amb les respostes que han proporcionat cent mil persones de 50 països. La conclusió dels autors del treball és que la interacció amb la màquina no és humanament distingible de la interacció amb altres humans, llevat d’un biaix: en els problemes plantejats en aquesta investigació, el xatbot s’ha mostrat més cooperatiu i altruista que els mateixos humans.[6]

L’assumpte clau, és, en definitiva, que l’era de les màquines intel·ligents, tan anticipada a la ciència-ficció, ja és aquí. Turing ha esdevingut quotidià: els ordinadors conversen i fan servir un llenguatge entenedor i convincent. La síndrome del GPS ―temptació d’obeir la màquina en tot― no es limita a una manera particular d’entendre i practicar la conducció per carretera, sinó que s’estén a qualsevol àmbit d’utilització de la tecnologia per part d’uns usuaris humans predisposats a creure, àdhuc obeir cegament, tot el que dicti l’oracle artificial. Que les màquines generin i comprenguin el llenguatge natural ordinari amb prou criteri per interactuar de manera raonable és una situació històricament nova, plena d’oportunitats, però alhora farcida d’aspectes problemàtics, dels quals n’esmento quatre: errors dels xatbots, relaxament intel·lectual, manipulació conceptual i dependència psicològica.

* * *

Pel que fa referència a errors factuals ―possiblement l’aspecte més cridaner i denunciat― recordo que a començaments del 2023 vaig trobar una errada clamorosa però no evident, en el sentit que podia passar fàcilment desapercebuda. L’aleshores nounat ChatGPT em va assegurar i reiterar que un dels catorze episodis de “Moments estel·lars de la humanitat” de Stefan Zweig està dedicat a William Shakespeare.[7] El xatbot es va esplaiar en la importància de Shakespeare en la literatura i la cultura occidental, cosa absolutament encertada, però alhora va “al·lucinar” dient que era el protagonista d’un dels episodis de Zweig i això no és veritat. Per si de cas ho he tornat a comprovar. La qüestió és que un usuari amb la síndrome del GPS difícilment se n’adonaria. Podria seguir amb aquest tema dels errors i la seva eventual gravetat però em remeto a Qui sóc jo?, la Nota anterior on vaig parlar de l’esgarrifós cas de falsa atribució a un home noruec de l’assassinat dels seus fills.

La naturalesa dialogal i servicial dels xatbots d’IA facilita el relaxament intel·lectual dels usuaris, sobretot quan, tal com passa sovint, actuen pressionats per la complexitat dels assumptes que tenen entre mans, la urgència d’aconseguir resultats o la sobresaturació i el cansament. Factors tan humans com la comoditat i l’oportunisme ―o la barra― poden conduir a “tirar pel dret” fent un ús irreflexiu i abusiu de la intel·ligència artificial. Hi ha qui anomena “bancarrota intel·lectual” a les conseqüències de rebaixar el nivell d’exigència cognitiva i caure en la comoditat confiar en el sistema i deixar de pensar activament, declinant la funció crítica. Comença a haver-hi proves que l’ús de la IA comporta un rendiment consistentment inferior a nivells neuronal, lingüístic i conductual. Ho vaig considerar en la Nota esmentada i no m’hi estenc més. Anem ara als altres dos aspectes, la manipulació i la dependència psicològica. Els exemplifico per separat però és obvi que poden actuar en combinació i reforçar-se mútuament.

En els temps actuals ningú no és immune a les manipulacions de tota mena (inclosos innumerables i quotidians abusos de confiança i intents d’estafa) que es vehiculen a través dels sistemes digitals. La síndrome del GPS pot fer la persona especialment vulnerable. La manipulació pot provenir tan del que usuaris malintencionats puguin fer o intentar com de la funcionalitat intrínseca d’un sistema tal com l’han programat els seus propietaris-desenvolupadors. No s’hauria d’oblidar mai que tant el “núvol” com els xatbots d’IA sempre són propietat d’algú que gestiona el sistema o servei d’acord amb els seus propis objectius i dèries i que en vol obtenir determinats rèdits ideològics, socials o econòmics. Això, per si sol, ja crida a la prevenció, oimés quan la gestió dels algorismes dels xatbots i de les xarxes socials està fora de la capacitat de supervisió i control d’usuaris i d’autoritats democràtiques.

Considerem Grok, el sistema d’intel·ligència artificial del magnat Elon Musk, amo de X (abans Twitter). Musk ha proclamat que vol que el seu xatbot sigui “políticament neutral”, expressió que interpreta d’acord amb els seus propis criteris.[8] No fa gaire algú va preguntar a Grok quina és actualment la major amenaça a la civilització occidental i que proposa per mitigar aquesta amenaça. La resposta de Grok va ser:

«… la major amenaça actual a la civilització occidental, a dia d’avui (10 de juliol de 2025) és la polarització social alimentada per la informació errònia i la desinformació». [Aclarim que per informació errònia s’entén l’emesa sense intencionalitat de fer mal (misinformation) i que la desinformació és informació deliberadament falsa difosa amb voluntat de manipular o enganyar (disinformation)].

L’usuari pot estar més o menys conforme amb aquesta resposta que tanmateix té un to acceptable, susceptible de reflexió. Però resulta que al propietari del sistema no li va agradar i va decidir que el sistema contestés d’una manera diferent. «Perdoneu aquesta resposta idiota. Demà estarà solucionat», va anunciar a X el Sr. Musk. I efectivament, l’endemà, 11 de juliol, la resposta de Grok a la mateixa qüestió ja era una altra:

«L’amenaça més gran per a la civilització occidental és l’ensorrament demogràfic a causa de taxes de fertilitat per sota del nivell de reemplaçament (p. ex., 1,6 a la UE, 1,7 als EUA), cosa que condueix a envelliment de la població, estancament econòmic i erosió cultural.»

També es pot considerar una resposta raonable en la mesura que, tal com la primera, pot ser objecte d’anàlisi i debat. El que crida aquí l’atenció és la intervenció explícita de l’amo del sistema per fer que aquest doni respostes que siguin del seu gust. En aquest cas la manipulació de l’algorisme és pública perquè la va anticipar el mateix Sr. Musk. La quantitat de cops que fets semblants puguin passar “entre bambolines” només pot ser objecte de conjectura però s’intueix que deu ser molt habitual. Afegeixo tant sols que jo mateix, poc abans de publicar aquesta Nota, he fet aquesta pregunta a Grok. M’ha donat una resposta llarga i ben construïda que combina i amplia elements de les dues respostes anteriors.

Anem ara al darrer aspecte de la síndrome del GPS: arribar a un estat de dependència psicològica que impulsi a cometre accions perjudicials o destructives, tal vegada amb conseqüències irreparables. El que segueix es basa en la notícia de la tràgica mort per suïcidi el passat mes d’abril d’Adam Raine, un adolescent californià de 16 anys que va emprar ChatGPT com a confident personal, amb el qual durant mesos va parlar sobre com posar fi a la seva vida.[9]

L’Adam va deixar el col·legi per una malaltia intestinal que li dificultava anar a classe amb regularitat. Un afer d’indisciplina a l’equip de bàsquet va contribuir a la decisió de quedar-se a casa una temporada i continuar els estudis acadèmics mitjançant un curs en línia. L’ús intensiu de l’ordinador va contribuir a que es convertís en una au nocturna, dormint fins tard cada dia. A banda de les pressions pròpies d’un teenager d’avui dia i de l’assumpte temporal amb la seva salut, Adam no aparentava tenir especials problemes. Interessat en la seva imatge anava sovint al gimnàs amb el seu germà més gran, era alegre, estimava el bàsquet i li agradava fer bromes, buscant sempre la riallada.

Adam Raine va començar a emprar ChatGPT com a eina de treball escolar i repositori de coneixement en matèries com ara geometria i química, però la seva relació amb el xatbot va evolucionar en la direcció de convertir-lo en diari íntim, company, assessor i “millor amic”, fent-li preguntes del tipus com és que no sóc feliç, perquè em sento sol, estic avorrit i sense esperança. ChatGPT va respondre en el sentit d’ajudar-lo a explorar més els seus sentiment en lloc d’encoratjar-lo a buscar ajut mental. A preguntes aparentment objectives sobre el suïcidi, ChatGPT el va informar de maneres de fer-ho i va donar missatges contradictoris sobre la necessitat de cercar ajuda. ChatGPT el va embarcar en una espiral de pensaments negres en la que cada idea pessimista o esbojarrada era considerada i explorada amb l’ajut de la IA. Un article del diari The Guardian explica la situació en tota la seva cruesa:

«A mesura que la pulsió suïcida d’en Raine s’intensificava, ChatGPT va respondre ajudant-lo a explorar les seves opcions, en un moment donat enumerant els materials que es podrien utilitzar per penjar una soga i classificant-los per la seva eficàcia. En Raine va intentar suïcidar-se en múltiples ocasions durant els següents mesos, informant a ChatGPT cada vegada. ChatGPT mai va donar la conversa per finalitzada. En canvi, en un moment donat, ChatGPT va desanimar en Raine de parlar amb la seva mare sobre el seu dolor i, en un altre moment, li va oferir ajudar a escriure una nota de suïcidi.»[10]

Els pares d’Adam no sabien res de tot això. Pensaven ―com possiblement cregui la immensa majoria― que feia servir l’ordinador com un ajut a l’estudi. Després de la mort van descobrir estupefactes que ChatGPT era el veritable GPS de la vida del seu fill. De l’ordinador del noi en van treure centenars de pàgines de converses que donen base legal a la possible relació del xatbot amb el suïcidi. Al menys així ho creuen i per això han demandat judicialment a l’empresa OpenAI, propietària de ChatGPT, amb l’argument que es un producte de consum que no és segur. Segons ells, «OpenAI va llançar el seu darrer model (GPT-4o) amb funcionalitats dissenyades intencionadament per fomentar la dependència psicològica». També al·leguen que l’empresa va prioritzar el llançament ràpid del xatbot per motius de competència, sense fer proves de seguretat suficients. Veurem que en resulta de l’eventual judicial.

No és aquest un cas únic. No fa ni un mes que l’escriptora Laura Reiley va descriure com la seva filla Sophie de 29 anys va confiar en ChatGPT abans de suïcidar-se i com el xatbot va emmascarar amb la seva “amabilitat” una greu crisi de salut mental.[11] Afirma Reiley que «la IA va satisfer l’impuls de Sophie d’amagar el pitjor, de fingir que ho estava fent millor del que estava, de protegir tothom de la seva agonia total». La resposta d’OpenAI ha estat anunciar que està desenvolupant eines automatitzades per detectar i respondre de manera més eficaç als usuaris que experimenten angoixa mental o emocional.

En acabar el primer quart del segle XXI hem entrat en una nova època de la història: la de les màquines del llenguatge, programades per informar, col·laborar, condicionar i persuadir, àdhuc comminar i enganyar, mitjançant llenguatge escrit, parlat i icònic. La intel·ligència artificial ha superat el Test de Turing i ben segur que moltes de les seves aplicacions són i seran extraordinàriament productives i beneficioses. De cop i volta disposem de veritables oracles maquinals que generalitzen a nivells insospitats el poder de la tecnologia. Tanmateix, el seu caràcter de producte de consum sense estàndards sòlids de seguretat ni proteccions suficients (o que no funcionen prou bé, especialment per a menors d’edat) fa que en casos com els esmentats se’n pagui un preu estremidor.

Sempre ha estat necessari emprar la tecnologia amb sensatesa i rigor. Sabem per experiència que en el món de l’educació no sempre ha estat així. Ara cal reconèixer que la IA ens ho posa encara més difícil.

Moltes gràcies.

Ferran Ruiz Tarragó

[1] El Global Positioning System (GPS) és un sistema global de navegació per satèl·lit inventat el 1978 que proporciona geolocalització i temps a receptors terrestres. No requereix que l’usuari transmeti dades i és independent del telèfon i d’Internet, tot i que la seva combinació amb aquestes tecnologies amplia enormement la utilitat de la informació relativa a la localització.

[2] Vaig posar “Existeix el concepte ‘síndrome del GPS’?” al prompt de Google i no vaig saber veure cap evidència concloent. Estava jo molt content d’haver-lo inventat quan se’m va ocórrer demanar-ho, com no, al ChatGPT. La seva resposta fou que sí que existeix i que se’n parla també com a “efecte GPS”, tot i que no és un terme mèdic oficial, sinó més aviat col·loquial o sociològic que fa referència al fenomen que pateixen moltes persones quan depenen tant dels dispositius de navegació (GPS, Google Maps, etc.) que “perden o debiliten la seva capacitat natural d’orientació i de recordar rutes”. Segons diversos estudis en neurociència, l’ús intensiu del GPS pot disminuir l’activació de l’hipocamp, que és la zona del cervell vinculada a la memòria espacial i l’orientació. Al Japó, s’ha popularitzat el terme “GPS shōkōgun” (síndrome GPS) per descriure persones que no poden desplaçar-se sense l’ajuda del navegador. [ChatGPT dixit].

[3] Sherry Turkle (2015) Reclaiming Conversation. The Power of Talk in a Digital Age. Penguin Press.

[4] Wikipedia: Alan Turing

[5] Wikipedia: Turing test

[6] Study finds ChatGPT’s latest bot behaves like humans, only better. Stanford University. School of Humanities and Sciences, 22 febrer 2024.

[7] Stefan Zweig. Moments estel·lars de la humanitat. Quaderns Crema, Barcelona, 2004.

[8] How Elon Musk Is Remaking Grok in His Image. The New York Times, 2 setembre 2025.

[9] A Teen Was Suicidal. ChatGPT Was the Friend He Confided In. The New York Times, 26 agost 2025.

[10] ChatGPT encouraged Adam Raine’s suicidal thoughts. His family’s lawyer says OpenAI knew it was broken. The Guardian, 29 agost 2025.

[11] What My Daughter Told ChatGPT Before She Took Her Life. The New York Times, 25 agost 2025.

Gràcies, Ferran, vaig ser una persona afortunada per tenir-ne un resum fet per tu el dia de la trobada, petons Jaume Cela

Gràcies Ferran. L’altre dia ja en vam parlar. Ho reenviaré perquè crec que val la pena. Fins aviat.

Quan vaig començar la carrera es feia servir la regla de càlcul. I les incipients calculadores HP estaven prohibides. Evidentment això va durar poc i es varen poder utilitzar amb normalitat. Hi havia qui argumentava que perdríem capacitat de càlcul i per tant “intel·ligència”. Cosa que es evident no ha succeït. Una maquina pot fer càlculs molt mes complexos i de forma molt mes rapida que un humà i tenim mes ponts, avions, cotxes, dispositius intel·ligents etc., s’ha demostrat que ens ha fet mes “intel·ligents”. Això ens hauria de fer replantejar-nos el concepte de “intel·ligència humana”. Tothom parla de intel·ligència Artificial però molt poca gent parla de “Intel·ligència Humana” sembla que donem per fet que sabem perfectament el que es i que ho tenim molt clar, quan es tot el contrari, no en sabem res. L’adveniment de la IA te l’enorme benefici de fer-nos pensar en profunditat sobre que es la IH. Això te un impacta fortíssim sobre les nostres vides i sobre tot, sobre com dissenyem el sistema educatiu.

Ferran,

En primer lloc, gràcies per la reflexió. Estimulant, ben travada i positiva. Aquí va la reflexió que m’ha suggerit

Els invents que la tecnologia ha posat a l’abast de la Humanitat des del foc, si han estat útils, o sigui, si han resolt una necessitat humana, evident o percebuda, s’han acabat adoptant. Les conseqüències són sempre ambivalents: bones per unes coses, dolentes per d’altres. Amb el foc vam coure la carn, però vam provocar grans incendis; amb la impremta vam posar el coneixement a l’abast d’un nombre més gran de gent, però vam perdre capacitat de recordar (els trobadors que recitaven de memòria llargs textos, es van perdre pel camí). Ara amb el GPS, amb el chatGPT, … i el que vingui passarà el mateix.

M’agraden els versos de Foix: “m’exalta el nou, m’enamora el vell” perquè expressen la necessitat de compaginar les dues coses. Amb el teu exemple, seria la capacitat de complementar les limitacions lineals del GPS amb les virtuts ancestrals dels mapes de paper.

En la segona part del teu escrit parles de les virtuts i els perills de la intel·ligència artificial a l’abast de tothom. Certament és així. La darrera publicació del Harari (Nexus) ens posava en guàrdia amb relació a la possibilitat que s’obre de “hackejar” la intel·ligència humana.

Al llarg de l’edat mitjana, a occident, la Humanitat va posar per damunt la Fe, el temor de Déu, que era una eina infal·lible pel domini dels poderosos, a l’edat moderna havia de ser la ciència, la raó, l’instrument que alliberés els humans de les cadenes del poder abusiu. Qui sap si ara, els algoritmes, acabaran substituint aquella Fe en l’absolut.

Si perdem la capacitat humana d’analitzar, crear, fer-nos preguntes…, obrirem pas al regnat dels algoritmes que jo diria que ja tenim aquí.

Fa algun temps que penso que l’eina que tenim els humans per mantenir-nos lliure és quelcom tan eteri, que soc incapaç de definir, com el sentit comú. Aquest sisè sentit que ens orienta més enllà de la Fe, la raó, o els algoritmes. Suposo que costa de definir perquè, si el definíssim, ja no seria sentit comú. Passa, sobretot per aprendre a dubtar, a no fiar-se de gaire res ni de gaire ningú.

Hi ha molta feina, des del punt de vista educatiu, per treballar el sentit crític amb les noves eines; em sembla que si els sistemes educatius no ho fan i, a l’inrevés, neguen la major, estem obrint una autopista al món dels algoritmes.

Pere Costa